Bonjour,

je me suis aperçu que des pages que j'avais publiées récemment n'étaient pas référencé dans google.

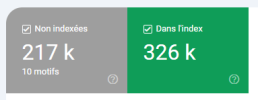

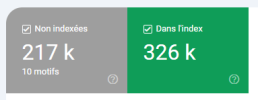

Je suis allé voir dans la google search console. Et là c'est l'horreur. Depuis avril des pages avec des paramètres chelous (ex: ?1198906982.shtml, ?Azspg2wrGB.doc, ?pjh5cgfyx.xml) ont progressivement envahi l'index google. Le site contient environ 90 000 pages mais voilà ce qu'affiche la console:

Ces pages parasites ont généré des erreurs 504.

Et google a fini par arrêter l'indexation le premier juillet.

Comment me débarrasser de toutes ces pages parasites?

Dans un premier temps, j'ai modifié l'htaccess pour ne plus avoir d'erreurs 504 et j'ai indiqué à la console que le problème était corrigé.

# Redirection des URL contenant des paramètres se terminant par .shtml, .xml ou .doc

RewriteCond %{QUERY_STRING} (.*)\.shtml$ [NC,OR]

RewriteCond %{QUERY_STRING} (.*)\.xml$ [NC,OR]

RewriteCond %{QUERY_STRING} (.*)\.doc$ [NC]

RewriteRule ^(.*)$ /$1? [R=301,L]

J'ai mis à jour et renvoyé les sitemaps.

A propos des sitempas, j'ai constaté que le bouton "voir l'indexation des pages" est inactivé.

D'où cela peut-il venir? C'est des sitemaps .txt avec la liste des urls. Vaut-il mieux un sitemap .xml (sur un autre site j'ai un sitemap .xml et pas ce problème).

Vos conseils sont les bienvenus.

Merci d'éviter les jugements.

je me suis aperçu que des pages que j'avais publiées récemment n'étaient pas référencé dans google.

Je suis allé voir dans la google search console. Et là c'est l'horreur. Depuis avril des pages avec des paramètres chelous (ex: ?1198906982.shtml, ?Azspg2wrGB.doc, ?pjh5cgfyx.xml) ont progressivement envahi l'index google. Le site contient environ 90 000 pages mais voilà ce qu'affiche la console:

Ces pages parasites ont généré des erreurs 504.

Et google a fini par arrêter l'indexation le premier juillet.

Comment me débarrasser de toutes ces pages parasites?

Dans un premier temps, j'ai modifié l'htaccess pour ne plus avoir d'erreurs 504 et j'ai indiqué à la console que le problème était corrigé.

# Redirection des URL contenant des paramètres se terminant par .shtml, .xml ou .doc

RewriteCond %{QUERY_STRING} (.*)\.shtml$ [NC,OR]

RewriteCond %{QUERY_STRING} (.*)\.xml$ [NC,OR]

RewriteCond %{QUERY_STRING} (.*)\.doc$ [NC]

RewriteRule ^(.*)$ /$1? [R=301,L]

J'ai mis à jour et renvoyé les sitemaps.

A propos des sitempas, j'ai constaté que le bouton "voir l'indexation des pages" est inactivé.

D'où cela peut-il venir? C'est des sitemaps .txt avec la liste des urls. Vaut-il mieux un sitemap .xml (sur un autre site j'ai un sitemap .xml et pas ce problème).

Vos conseils sont les bienvenus.

Merci d'éviter les jugements.