Il est bien plus courant qu'on ne l'imagine d'avoir besoin de désindexer des pages de Google, c'est-à-dire de les supprimer de l'index... Bonne lecture et commentaires/questions ! Partages et liens appréciés :roll:

Comment supprimer des pages de Google (désindexation)

- Auteur de la discussion WebRankInfo

- Date de début

Nouveau WRInaute

utiliser la rubrique du webmaster

exemple :https://www.google.com/webmasters/tools/url-removal?hl=fr&siteUrl=http://monsite.com

exemple :https://www.google.com/webmasters/tools/url-removal?hl=fr&siteUrl=http://monsite.com

Bonjour à tous,

je suis entrain de bosser sur les pages de mon site et en lancant une requete sur les "pages de destination" de GA, je vois plein d'URL qui n'existent pas/plus dans l'index de google ( j'ai tapé l'url complete entre guillemet pour vérifier dans le moteur de recherche).

Dois je ignorer ces pages donc ou faire une action spécifique ?

Merci pour vos retours.

je suis entrain de bosser sur les pages de mon site et en lancant une requete sur les "pages de destination" de GA, je vois plein d'URL qui n'existent pas/plus dans l'index de google ( j'ai tapé l'url complete entre guillemet pour vérifier dans le moteur de recherche).

Dois je ignorer ces pages donc ou faire une action spécifique ?

Merci pour vos retours.

Tu as deux solutions :toutatix a dit:Bonjour à tous,

je suis entrain de bosser sur les pages de mon site et en lancant une requete sur les "pages de destination" de GA, je vois plein d'URL qui n'existent pas/plus dans l'index de google ( j'ai tapé l'url complete entre guillemet pour vérifier dans le moteur de recherche).

Dois je ignorer ces pages donc ou faire une action spécifique ?

Merci pour vos retours.

- Ignorer car cela finira par être désindexé tôt ou tard

- Accélérer le processus en faisant une demande de suppression

Concernant mon expérience avec l'outil permettant de faire une demande de suppression d'URL sur 46 demandes la totalité ont était supprimé en 24h, grand max.

avant d'en demander la suppression, il faut bien entendu se demander si ces pages doivent être indexées.

si oui : il faut comprendre pourquoi elles ne le sont pas (pb technique ? pb de qualité insuffisante ? pour le vérifier, lance un audit RM Tech puis suis les étapes QualityRisk / Zombies)

si non : il faut comprendre pourquoi elles ont été laissées indexables sur le site et corriger ça. En plus, il faut en demander la désindexation

si oui : il faut comprendre pourquoi elles ne le sont pas (pb technique ? pb de qualité insuffisante ? pour le vérifier, lance un audit RM Tech puis suis les étapes QualityRisk / Zombies)

si non : il faut comprendre pourquoi elles ont été laissées indexables sur le site et corriger ça. En plus, il faut en demander la désindexation

Membre Honoré

Bonjour katagency,

Oui, dans la limite indiquée par Google via l'aide.

Complément : Remove URLs Tool.

Cordialement.

Oui, dans la limite indiquée par Google via l'aide.

Complément : Remove URLs Tool.

Cordialement.

je te propose de lire + d'infos dans mon article https://www.webrankinfo.com/dossiers/gwt/suppression-pages-google

Nouveau WRInaute

Bonjour,

J'ai lut votre post sur la suppression des url.

En l'occurrence j'ai environ 1500 URL qui n'existe plus et pour cause.

Elles faisaient partie d'un sous dossier "preprod" dans lequel il y avait une version de mon site pour les tests.

J’ai rajouté dans mon fichier robot.txt la ligne « Disallow: */preprod/ » et mis quelques url en suppression dans Google Search Console mais suis loin d’avoir fini.

J’ai crue comprendre que l’on pouvait utiliser un fichier sitemap pour supprimer ces URL mais je ne comprends pas très bien comment le mettre en place.

Simplement en écrivant les URL (une par ligne) ? Sans mettre de balises < ?xml ><urlset><url><loc>… ?

Comment Google fera la différence entre mon fichier sitemap où j’ai les url à indexer et l’autre ou les url sont à désindexer ?

http://www.joaillerie-jos.com

Merci de votre retour.

J'ai lut votre post sur la suppression des url.

En l'occurrence j'ai environ 1500 URL qui n'existe plus et pour cause.

Elles faisaient partie d'un sous dossier "preprod" dans lequel il y avait une version de mon site pour les tests.

J’ai rajouté dans mon fichier robot.txt la ligne « Disallow: */preprod/ » et mis quelques url en suppression dans Google Search Console mais suis loin d’avoir fini.

J’ai crue comprendre que l’on pouvait utiliser un fichier sitemap pour supprimer ces URL mais je ne comprends pas très bien comment le mettre en place.

Simplement en écrivant les URL (une par ligne) ? Sans mettre de balises < ?xml ><urlset><url><loc>… ?

Comment Google fera la différence entre mon fichier sitemap où j’ai les url à indexer et l’autre ou les url sont à désindexer ?

http://www.joaillerie-jos.com

Merci de votre retour.

si tout est dans un répertoire /preprod/, alors c'est très simple :

1- supprimer le répertoire /preprod/ du serveur

2- faire une demande de suppression de l'index Google du répertoire /preprod/ dans Search Console

le lendemain tout sera supprimé

voir aussi mes conseils pour gérer un site en pré-prod

1- supprimer le répertoire /preprod/ du serveur

2- faire une demande de suppression de l'index Google du répertoire /preprod/ dans Search Console

le lendemain tout sera supprimé

voir aussi mes conseils pour gérer un site en pré-prod

Nouveau WRInaute

Bonjour et merci pour votre retour.

Je n'avais pas compris que l'on pouvais directement désindexer un dossier.

Excellente journée

Je n'avais pas compris que l'on pouvais directement désindexer un dossier.

Excellente journée

Bonjour,

J'ai suivi tous les conseils pour désindexer les pages d'un site en développement dont le htpassword a été enlevé quelques jours suite à un problème. J'ai utiliser la google search consol "url à supprimer" et aussi google search consol "supprimer le contenu obsolète" mais au bout de 6 jours toutes les url ré-apparaissent dans google, cela ne devrait pas être 90 jours? Dans la console il est mentionné "expirée" alors que j'ai fait la manip' il y a pas longtemps.

Le htpassword a été remis depuis longtemps je ne comprend pas pourquoi la durée de 90 jours n'est pas pris en compte? Je viens de voir la technique proposée des bookmarklets très pratique car je me suis tapée à la main les 14 pages de google à désindéxer et les revoir apparaître au bout de 6 jours c'est désespérant.

J'ai suivi tous les conseils pour désindexer les pages d'un site en développement dont le htpassword a été enlevé quelques jours suite à un problème. J'ai utiliser la google search consol "url à supprimer" et aussi google search consol "supprimer le contenu obsolète" mais au bout de 6 jours toutes les url ré-apparaissent dans google, cela ne devrait pas être 90 jours? Dans la console il est mentionné "expirée" alors que j'ai fait la manip' il y a pas longtemps.

Le htpassword a été remis depuis longtemps je ne comprend pas pourquoi la durée de 90 jours n'est pas pris en compte? Je viens de voir la technique proposée des bookmarklets très pratique car je me suis tapée à la main les 14 pages de google à désindéxer et les revoir apparaître au bout de 6 jours c'est désespérant.

est-ce que les URL concernées étaient dans un sous-domaine à part, ou un répertoire à part ? car dans ce cas c'est très simple

Merci pour votre réponse, c’est un sous domaine, un environnement de développement genreWebRankInfo a dit:est-ce que les URL concernées étaient dans un sous-domaine à part, ou un répertoire à part ? car dans ce cas c'est très simple

dev.nomdedomaine.fr

il suffit de déclarer ce sous-domaine dans search console puis d'en demander la désindexation totale

ensuite il peut être retiré de search console

à l'avenir bien entendu, tout environnement de préprod doit être protégé par un accès via mot de passe

ensuite il peut être retiré de search console

à l'avenir bien entendu, tout environnement de préprod doit être protégé par un accès via mot de passe

Nouveau WRInaute

Il est bien plus courant qu'on ne l'imagine d'avoir besoin de désindexer des pages de Google, c'est-à-dire de les supprimer de l'index... Bonne lecture et commentaires/questions ! Partages et liens appréciés :roll:

Bonjour

J'ai lu votre article sur la désindexation des pages et je me demandais simplement comment Google fait la distinction entre pages à indexer/désindexer à travers le sitemap.

Deuxièmement, j'ai cherché un peu sur l'utilité d'un sitemap et à ma surprise, souvent il est déconseillé d'en utiliser, ou QUE lorsque nous avons des nouvelles pages à indexer (ce qui renvoie à ma première question)

Merci pour vos éclaircissements !

Apparemment, tu n'as pas assez lu mon article...

J'explique que pour désindexer une page il faut la mettre dans une situation telle qu'elle ne sera pas / plus indexable. Par exemple mettre une balise meta robots noindex.

Ensuite, soit on a la chance que toutes les pages à désindexer se trouvent toutes dans un répertoire et que ce répertoire ne contienne que des pages à désindexer (dans ce cas c'est très simple).

Soit il faut inciter Google à crawler les pages pour constater qu'on veut les faire désindexer. D'où l'idée du sitemap (temporaire) dans ce cas précis.

Je ne comprends pas pourquoi quelqu'un irait déconseiller d'utiliser un sitemap ? quelles sont les raisons évoquées ?

J'explique que pour désindexer une page il faut la mettre dans une situation telle qu'elle ne sera pas / plus indexable. Par exemple mettre une balise meta robots noindex.

Ensuite, soit on a la chance que toutes les pages à désindexer se trouvent toutes dans un répertoire et que ce répertoire ne contienne que des pages à désindexer (dans ce cas c'est très simple).

Soit il faut inciter Google à crawler les pages pour constater qu'on veut les faire désindexer. D'où l'idée du sitemap (temporaire) dans ce cas précis.

Je ne comprends pas pourquoi quelqu'un irait déconseiller d'utiliser un sitemap ? quelles sont les raisons évoquées ?

Nouveau WRInaute

Apparemment, tu n'as pas assez lu mon article...

J'explique que pour désindexer une page il faut la mettre dans une situation telle qu'elle ne sera pas / plus indexable. Par exemple mettre une balise meta robots noindex.

Ensuite, soit on a la chance que toutes les pages à désindexer se trouvent toutes dans un répertoire et que ce répertoire ne contienne que des pages à désindexer (dans ce cas c'est très simple).

Soit il faut inciter Google à crawler les pages pour constater qu'on veut les faire désindexer. D'où l'idée du sitemap (temporaire) dans ce cas précis.

Je ne comprends pas pourquoi quelqu'un irait déconseiller d'utiliser un sitemap ? quelles sont les raisons évoquées ?

En effet, je l'ai lu un peu de travers

Mon problème est que je ne peux mettre une balise meta car je n'ai pas accès aux pages (voir mon autre discussion ici ) Du coup je partait sur le principe de créer un sitemap mais je n'arrive pas à comprendre comment Google saura que ce sitemap contient des URL à désindexer. De plus, les fichiers sont quasiment tous à la racine, ou dans des répertoire qui ne sont plus accessibles non plus.

Un exemple de site qui le déconseillait était ce site par exemple (certes, de 2015...)

Merci

Membre Honoré

Bonjour,

Temps de réponse : 5 minutes.

Cordialement.

Article : Supprimer des pages de l’index Google via Search Console.Mon problème est que je ne peux mettre une balise meta car je n'ai pas accès aux pages

Temps de réponse : 5 minutes.

Cordialement.

l'article que tu cites dit quelques bêtises (selon moi) et indique bcp d'avantages au sitemap, dont :

- Pour désindexer des pages: C’est bien pratique lorsqu’on veux accélérer la désindexation de certaines pages. Plutôt que d’attendre 3 mois que Google revienne crawler les pages qu’on veux désindexer, un bon sitemap XML et hop c’est fait.

Nouveau WRInaute

Bonjour,

Comme la conversation a 1 an déjà, je me permet de revenir poser une question bête.

Suite à des comparaisons de multiples crawls de mon site pratique.fr avec My Rankings Metrics, j'ai demandé à mon DBA de me mettre 3700 actus bien périmées, pas de clics, impressions... en noindex. J'ai aussi préparé le fichier à uploader sur la Search Console.

Et là je me pose la question bien bête de comment je déclare ce fichier pour la Search au milieu de mes beaux sitemap ? Je peux l'appeler desindex par exemple, Google va passer dessus et avec le temps, elles vont dégager.

Je sais que l'article d'Olivier est très clair là-dessus mais on a fait tellement de conneries sur ce site que je préfère passer pour une tanche à vos yeux

Comme la conversation a 1 an déjà, je me permet de revenir poser une question bête.

Suite à des comparaisons de multiples crawls de mon site pratique.fr avec My Rankings Metrics, j'ai demandé à mon DBA de me mettre 3700 actus bien périmées, pas de clics, impressions... en noindex. J'ai aussi préparé le fichier à uploader sur la Search Console.

Et là je me pose la question bien bête de comment je déclare ce fichier pour la Search au milieu de mes beaux sitemap ? Je peux l'appeler desindex par exemple, Google va passer dessus et avec le temps, elles vont dégager.

Je sais que l'article d'Olivier est très clair là-dessus mais on a fait tellement de conneries sur ce site que je préfère passer pour une tanche à vos yeux

si tu es certaine de vouloir les désindexer, tu peux en effet fournir un sitemap qui les liste. Certes, Google va alerter qu'il ne peut pas les indexer, mais ça va accélérer la désindexation. Quand elles seront désindexées, tu pourras supprimer le sitemap. Bref, je ne fais que répéter mon article ;-)

au passage, si elles sont si périmées que ça, pourquoi les laisser sur le site ?

au passage, si elles sont si périmées que ça, pourquoi les laisser sur le site ?

Nouveau WRInaute

Hello

Merci pour ta réponse !

Ben débat avec le Dba sur la question justement, il me disait 410 et nouvelle règle avec les actus qu'on fait actuellement. Genre du noindex au bout de 1an et 410 après pour celles qui ne font pas de trafic.

Bref ça cogite, je ne suis pas seo analyst mais parfois la logique humaine c'est pas mal !

Merci pour ta réponse !

Ben débat avec le Dba sur la question justement, il me disait 410 et nouvelle règle avec les actus qu'on fait actuellement. Genre du noindex au bout de 1an et 410 après pour celles qui ne font pas de trafic.

Bref ça cogite, je ne suis pas seo analyst mais parfois la logique humaine c'est pas mal !

le blocage par mot de passe (qui est à faire dans 100% des cas de dév/preprod) ne fait que bloquer le crawler, ça ne désindexe pas. Pour ça, lire mon article : comment désindexer un sous-domaine ?

WRInaute occasionnel

le blocage par mot de passe (qui est à faire dans 100% des cas de dév/preprod) ne fait que bloquer le crawler, ça ne désindexe pas. Pour ça, lire mon article : comment désindexer un sous-domaine ?

Merci j'ai entre temps demandé la suppression du Ndd via la search console et j'ai quand même ajouté un htaccess/htpassword et ce matin plus rien...

Je suis étonné de la rapidité du truc..

Merci en tout cas pour l'article qui m'a bcp aidé

oui c'est rapide, quelques heures en général

WRInaute discret

Bonjour,

J'ai suivi les instructions en créant un sitemap avec les URL à désindexer. Chaque page présente à une balise Noindex et n'est pas bloqué par le robots.txt.

J'ai soumis le sitemap le 12/02/20 et la dernière lecture date du 26/02/20. Mais les désindexations ne vont pas super vite. J'en ai 26 sur 657 pour le moment.

Est-ce normal ? Ai-je oublié quelque chose ?

Bonne journée,

Philippe

J'ai suivi les instructions en créant un sitemap avec les URL à désindexer. Chaque page présente à une balise Noindex et n'est pas bloqué par le robots.txt.

J'ai soumis le sitemap le 12/02/20 et la dernière lecture date du 26/02/20. Mais les désindexations ne vont pas super vite. J'en ai 26 sur 657 pour le moment.

Est-ce normal ? Ai-je oublié quelque chose ?

Bonne journée,

Philippe

26 indexées ou 26 désindexées ? tu regardes comment pour le savoir ?

WRInaute discret

26 désindexées sur les 657. Je prends en compte les pages qui ont été crawlé et qui ressortent en erreur "URL envoyée désignée comme "noindex".

J'en ai 5 sinon en "Explorée, actuellement non indexée" dans les exclues mais elles n'ont pas été crawlé avant la mise en place de ce sitemap donc elles étaient déjà désindexées avant.

Il en reste 582 actuellement en envoyées et indéxées avec des dates de dernière exploration allant du 30 Avril 2019 au 9 Février 2020.

J'en ai 5 sinon en "Explorée, actuellement non indexée" dans les exclues mais elles n'ont pas été crawlé avant la mise en place de ce sitemap donc elles étaient déjà désindexées avant.

Il en reste 582 actuellement en envoyées et indéxées avec des dates de dernière exploration allant du 30 Avril 2019 au 9 Février 2020.

étonnant, Google n'a crawlé aucune URL depuis l'envoi de ce sitemap ?

il doit s'agir d'URL avec un PageRank hyper faible.

ces URL ne reçoivent plus aucun lien en interne, n'est-ce pas ?

il doit s'agir d'URL avec un PageRank hyper faible.

ces URL ne reçoivent plus aucun lien en interne, n'est-ce pas ?

ces URL ne reçoivent plus aucun lien en interne, n'est-ce pas ?

WRInaute discret

étonnant, Google n'a crawlé aucune URL depuis l'envoi de ce sitemap ?

il doit s'agir d'URL avec un PageRank hyper faible.

ces URL ne reçoivent plus aucun lien en interne, n'est-ce pas ?

Il en a crawlé quelques unes (les 26 désindéxées) mais pas plus.

Et normalement non elles ne reçoivent pas de lien.

"normalement" ce n'est pas suffisant, tu devrais le vérifier par un crawl

WRInaute discret

"normalement" ce n'est pas suffisant, tu devrais le vérifier par un crawl

Il y a beaucoup de page à crawler, je ne peux pas les vérifier une par une mais pour celles que j'ai testé avec Screaming Frog c'était ok. Les autres correspondent au même schéma donc il ne doit plus avoir de liens qui mènent vers ces pages.

OK, même si je ne vois pas comment tu peux en tester quelques unes, puisque par définition il faut crawler 100% du site.

Peut-être que Google n'est pas pressé de les crawler car ce sont des vieilles URL, secondaires

Peut-être que Google n'est pas pressé de les crawler car ce sont des vieilles URL, secondaires

WRInaute discret

OK, même si je ne vois pas comment tu peux en tester quelques unes, puisque par définition il faut crawler 100% du site.

Peut-être que Google n'est pas pressé de les crawler car ce sont des vieilles URL, secondaires

Je crawle tout le site mais il faudrait que j'aille voir les Inlinks de chacune des 657 pages pour savoir si des liens mènent vers chacune d'entre elles.

je ne vois pas la difficulté : si tu crawles tout le site, tu ne dois pas trouver ces URL, c'est tout. si c'est le cas, tu n'as rien à tester. sinon, tu dois en effet regarder les inlinks des quelques URL que tu auras trouvées

WRInaute discret

je ne vois pas la difficulté : si tu crawles tout le site, tu ne dois pas trouver ces URL, c'est tout. si c'est le cas, tu n'as rien à tester. sinon, tu dois en effet regarder les inlinks des quelques URL que tu auras trouvées

Oui du coup je suis obligé de rechercher dans mes URL de mon crawl si je trouve pas une de mes 627 URL que je veux désindexer ? Ce qui prends un temps fou.

Ou alors je m'y prends mal ?

Nouveau WRInaute

Connectez-vous à la Google Search Console et sélectionnez le site Web souhaité.

Cliquez sur «Optimisation» dans la navigation de gauche.

Cliquez sur «Supprimer l'URL» dans le sous-menu.

Cliquez sur le bouton «créer une nouvelle demande de suppression» sur cette page.

Cliquez sur «Optimisation» dans la navigation de gauche.

Cliquez sur «Supprimer l'URL» dans le sous-menu.

Cliquez sur le bouton «créer une nouvelle demande de suppression» sur cette page.

WRInaute discret

Connectez-vous à la Google Search Console et sélectionnez le site Web souhaité.

Cliquez sur «Optimisation» dans la navigation de gauche.

Cliquez sur «Supprimer l'URL» dans le sous-menu.

Cliquez sur le bouton «créer une nouvelle demande de suppression» sur cette page.

Ça ne fonctionne pas : cf https://www.webrankinfo.com/forum/t/outil-suppression-gsc.197384/

jusqu'à présent c'était pas un préfixe d'URL mais un répertoire. Avec la nouvelle version, Google semble indiquer qu'il sait gérer un préfixe d'URL mais comme c'est assez récent, je ne l'ai pas encore testé.

Nouveau WRInaute

Oui du coup je suis obligé de rechercher dans mes URL de mon crawl si je trouve pas une de mes 627 URL que je veux désindexer ? Ce qui prends un temps fou.

Ou alors je m'y prends mal ?

B

Dernière édition:

Je n'ai jamais eu besoin de faire une suppression temporaire (à chaque fois, la page était supprimée du site, ou passée non indexable, donc la désindexation est définitive). C'est quoi le pb des 30 jours ?

Mon post avait pour but de répondre à la question : combien dure une suspension temporaire. Je croyais que c'était 6 mois, mais je ne sais plus où j'ai trouvé cette information. Mais je constate qu'en fait, c'est moins de 30 jours. Donc, cela ne sert quasiment à rien. J'ai refait une demande hier, cela a été validé, je vais surveiller pour voir combien cela dure.

tu espères que ce soit permanent et non temporaire ?

Je déterre un vieux sujet

J'ai deux soucis (mais qui aboutissent à la même problématique au final):

- j'ai fait une boulette il y a quelques mois avec ma gestion des liens et Google a indexé des centaines de pages qui n'existaient pas vraiment, ces liens étaient automatiquement redirigés vers une page de plus haut niveau

- j'ai supprimé quelques articles dans mon blog en mettant une redirection permanente vers un niveau plus haut

Dans les deux cas aujourd'hui, j'utilise une redirection permanente pour indiquer à Google qu'il doit les oublier et d'un point de vue de l'indexation cela a fonctionné car je les retrouve dans la section des pages non indexées de la console. Mon problème c'est que Google continue à passer sur ces urls alors que ça ne sert à rien et je pense que ça impacte mon budget de crawl parce que la publication de nouvelles pages dans l'index semble plus lente.

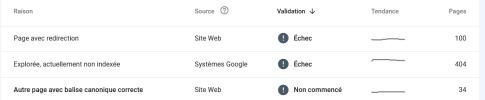

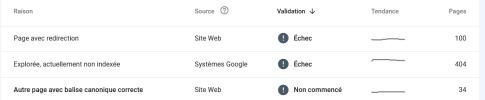

Voici un exemple:

Une grande partie de ces pages se trouve dans "page avec redirection", j'ai envie de dire...ben oui...c'est une redirection permanente mais pourquoi toujours les afficher dans le rapport? Pareil pour "explorée, actuellement non indexée". Ici aussi ce sont des redirections permanentes et pourtant ça revient tout le temps. J'ai tenté de faire repasser Google sur ces pages avec la fonction de résolution de problème mais elle finit toujours en échec comme vous pouvez le voir sur la capture d'écran.

Est-ce que cela peut poser problème dans mon budget de crawl? Si oui, comment pourrais-je m'en débarrasser une fois pour toute?

Merci

J'ai deux soucis (mais qui aboutissent à la même problématique au final):

- j'ai fait une boulette il y a quelques mois avec ma gestion des liens et Google a indexé des centaines de pages qui n'existaient pas vraiment, ces liens étaient automatiquement redirigés vers une page de plus haut niveau

- j'ai supprimé quelques articles dans mon blog en mettant une redirection permanente vers un niveau plus haut

Dans les deux cas aujourd'hui, j'utilise une redirection permanente pour indiquer à Google qu'il doit les oublier et d'un point de vue de l'indexation cela a fonctionné car je les retrouve dans la section des pages non indexées de la console. Mon problème c'est que Google continue à passer sur ces urls alors que ça ne sert à rien et je pense que ça impacte mon budget de crawl parce que la publication de nouvelles pages dans l'index semble plus lente.

Voici un exemple:

Une grande partie de ces pages se trouve dans "page avec redirection", j'ai envie de dire...ben oui...c'est une redirection permanente mais pourquoi toujours les afficher dans le rapport? Pareil pour "explorée, actuellement non indexée". Ici aussi ce sont des redirections permanentes et pourtant ça revient tout le temps. J'ai tenté de faire repasser Google sur ces pages avec la fonction de résolution de problème mais elle finit toujours en échec comme vous pouvez le voir sur la capture d'écran.

Est-ce que cela peut poser problème dans mon budget de crawl? Si oui, comment pourrais-je m'en débarrasser une fois pour toute?

Merci

ces mentions de redirections sont logiques puisque tu en as généré plein sur le site (ce qu'il aurait fallu éviter). il faut juste vérifier que :

- en interne, il ne reste plus aucun lien vers une redirection

- chaque redirection se fait en 1 fois, pas en plusieurs étapes, et c'est une 301

le budget de crawl ne concerne pas ton site, il n'a pas 100k URL ou plus je suppose ?

- en interne, il ne reste plus aucun lien vers une redirection

- chaque redirection se fait en 1 fois, pas en plusieurs étapes, et c'est une 301

le budget de crawl ne concerne pas ton site, il n'a pas 100k URL ou plus je suppose ?

WRInaute discret

Bonjour Olivier,

J'ai repris un site d'actu très ancien avec plus de 60.000 pages (sur plus de 300.000) qui datent de 5 ans et plus et sont considérés comme "Explorée mais non indexées". La plupart sont d'une trop faible qualité (texte trop court entre 50 et 150 mots) mais compte tenu de la quantité de pages, il est impossible de les améliorer. Quelle est la meilleure stratégie par rapport à Google afin que le bot les oublie ?

merci

J'ai repris un site d'actu très ancien avec plus de 60.000 pages (sur plus de 300.000) qui datent de 5 ans et plus et sont considérés comme "Explorée mais non indexées". La plupart sont d'une trop faible qualité (texte trop court entre 50 et 150 mots) mais compte tenu de la quantité de pages, il est impossible de les améliorer. Quelle est la meilleure stratégie par rapport à Google afin que le bot les oublie ?

merci

à ta place, je ferais tout de même très attention avant de supprimer 60.000 pages, de bien choisir les critères

mais pour répondre à ta question : il faudrait que Google ne trouve plus de liens vers ces pages, qu'elles soient retirées des sitemaps. Et encore, il continuerait sans doute d'en crawler une partie. Mais à quoi bon conserver ces pages sur le site si c'est pour retirer tous les liens vers elles ?

mais pour répondre à ta question : il faudrait que Google ne trouve plus de liens vers ces pages, qu'elles soient retirées des sitemaps. Et encore, il continuerait sans doute d'en crawler une partie. Mais à quoi bon conserver ces pages sur le site si c'est pour retirer tous les liens vers elles ?

WRInaute discret

"Mais à quoi bon conserver ces pages sur le site si c'est pour retirer tous les liens vers elles ?"

Tu préconises quel critère de retrait ? La longueur des textes me semble en être un bon (afin d'éliminer déjà les pages vraiment d'un très faible intérêt).

merci

Tu préconises quel critère de retrait ? La longueur des textes me semble en être un bon (afin d'éliminer déjà les pages vraiment d'un très faible intérêt).

merci

j'ai développé un indice noté Quality Risk qui évalue à quel point une page cumule des problèmes. Un des critères est le manque de texte (nb de mots) dans la zone principale de la page, en tenant compte du type de page (un article de blog est censé avoir + de mots qu'une page de catégorie).

Je ne veux pas donner de conseil générique qui soit partiellement repris, pour ensuite qu'on me dise que la suppression des pages a été une catastrophe. Il faut juger l'ensemble.

Je ne veux pas donner de conseil générique qui soit partiellement repris, pour ensuite qu'on me dise que la suppression des pages a été une catastrophe. Il faut juger l'ensemble.

WRInaute discret

Ok, merci. Bonne journée à toutes et tous

Hello Olivier,ces mentions de redirections sont logiques puisque tu en as généré plein sur le site (ce qu'il aurait fallu éviter). il faut juste vérifier que :

- en interne, il ne reste plus aucun lien vers une redirection

- chaque redirection se fait en 1 fois, pas en plusieurs étapes, et c'est une 301

le budget de crawl ne concerne pas ton site, il n'a pas 100k URL ou plus je suppose ?

je reviens sur ce point parce que je constate quelque chose d'assez flagrant. J'observe une augmentation de trafic depuis que la désindexation a commencé et elle continue à croitre à chaque baisse du nombre de pages indexées. Le site en question n'a pourtant pas plus de 1000 urls. Les baisses en indexaction correspondent aux augmentations de trafic.

➡️ Offre MyRankingMetrics ⬅️

pré-audit SEO gratuit avec RM Tech (+ avis d'expert)

coaching offert aux clients (avec Olivier Duffez ou Fabien Faceries)

Voir les détails ici

Discussions similaires

- Réponses

- 2

- Affichages

- 1K

- Réponses

- 2

- Affichages

- 2K

- Réponses

- 3

- Affichages

- 2K

- Réponses

- 4

- Affichages

- 3K

- Réponses

- 7

- Affichages

- 3K

- Réponses

- 3

- Affichages

- 3K

- Réponses

- 1

- Affichages

- 2K

- Réponses

- 2

- Affichages

- 2K

- Réponses

- 2

- Affichages

- 4K

- Réponses

- 3

- Affichages

- 7K

- Réponses

- 6

- Affichages

- 2K

- Réponses

- 5

- Affichages

- 5K

- Réponses

- 10

- Affichages

- 2K

- Réponses

- 10

- Affichages

- 5K

N

- Réponses

- 2

- Affichages

- 3K

- Réponses

- 9

- Affichages

- 3K

- Réponses

- 2

- Affichages

- 2K

- Réponses

- 17

- Affichages

- 3K

- Réponses

- 4

- Affichages

- 4K